「カメラコントロール」もApple Intelligenceに通ず

Apple Intelligenceへの注力に関しては、プロセッサー以外からも傾向が読み取れる。

iPhone 16シリーズには「カメラコントロール」という新しいボタンが搭載された。これは単なる押しボタンではなく、タッチセンサーを併用してズーム変更や撮影設定変更もできるというもの。画面をタッチせずにカメラを素早く操作するという意味で、かなり面白い機構である。

ただこの機能は「写真や動画を撮影する」ために搭載されているわけではない。Apple Intelligenceとの組み合わせにより、「自分の周囲の写真からの情報を活用する」ことができるようになる。ポスターからスケジュールを生成したり、気になった商品を検索したりといった使い方だ。

要はAndroidにおける「Googleレンズ」なのだが、iPhone内のさまざまなアプリとの連携が強化されていることなど、使い勝手は変わってくるだろう。

また、カメラコントロールという専用ボタンがあり、それが「スマホを縦持ちした時に押しやすい」位置にあることも大きい。「軽く押してApple Intelligenceを起動する」ような使い方もできるわけだ。

昨年、iPhone 15 Proシリーズには「アクションボタン」が追加された。カメラの起動はこれでもできるのだが、アップルはまた別のUIを、カメラとAIのために用意してきた。それも、上位モデルだけでなく全モデルにである。

カメラなどのUI刷新という観点だけでなく、「Apple Intelligenceへの注力」を示すものであるのは疑いない。

健康や音声での「機械学習」による差別化はアップルの強み

とはいえ、日本でApple Intelligenceが使えるようになるのは2025年になってからだ。2025年のいつ、というアナウンスはないが、もっとも長い場合、ほぼ1年先まで使えない可能性もある。「だったら今年は……」という発想も出てくるだろう。

では、アップルが新機軸を別に用意していないのか、というとそうではない。新機軸は周辺機器での「機械学習活用」にある。

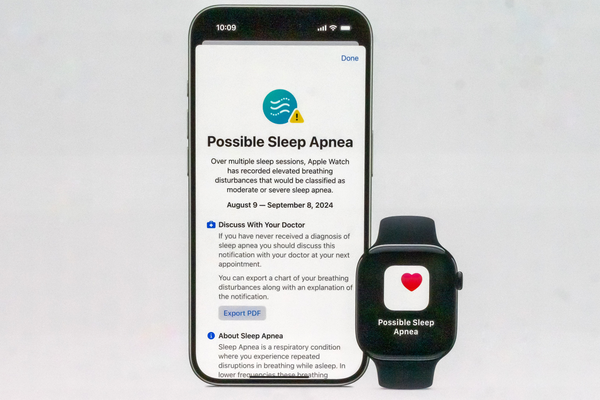

「Apple Watch Series 10」などに搭載された「睡眠時無呼吸の兆候検出機能」や、「AirPods Pro 2」へのソフトウエアアップグレードで提供される「聴覚の健康をサポートする機能」だ。

どちらも健康に関わるものだが、重要なのは、医療用の特別なハードウエアを使っているわけではない、ということだ。

医療機器として診断に使われる機器は精密なもので、民生品で同じデータは得られない。だが民生品であっても、科学的裏付けのあるデータ収集と解析手法を使うことで、健康の維持や病気の予兆検知を助ける情報を得ることはできる。それを可能にするのは「研究に裏付けされた機械学習処理」だ。

そうしたアプローチはアップルだけが実施しているわけではないが、特にアップルが熱心に開発し、製品化している領域であることは疑いない。

またiPhone 16 Proシリーズでは、「ビデオ撮影時の空間オーディオ収録と編集」や、「録音済みの曲に合わせて声を重ね後から調整する」というマルチトラック収録的な機能もある。これらも音声に高度な機械学習処理を重ねることで実現されている。

「AIと機械学習」という書き方をしたが、実のところ、両者に大きな差はない。処理の規模や方向性が違うだけだ。同じiOSの中でも、AIと機械学習処理は両方入っているし、機能によっては機械学習が「AI」と呼ばれているものもある。

Apple Intelligenceがまだ使えなくても、アップルが開発した「機械学習による機能」は製品全体に組み込まれている。それらを魅力的だと感じたら、使い続ければいい。iPhone 16を買わなかったとしても、それら新機能が与えてくれる価値は小さいものではない。

そしてなにより、それらの周辺機器や新機能は、結局のところ「iPhoneなどのアップル製品を使い続ける」モチベーションになる。アップルから見れば、同社のエコシステムに入っていてくれれば、いつかは「最新のiPhoneやMac」を買ってくれる可能性につながる。

その結果として、Apple Intelligenceも普及していく……ということになるのだ。